Testează AI pe site-ul TĂU în 60 de secunde

Vezi cum inteligența noastră artificială îți analizează instantaneu site-ul web și creează un chatbot personalizat - fără înregistrare. Introduci doar URL-ul tău și privești cum funcționează!

Zorii AI moderne: înțelegerea GPT

Ceea ce a făcut GPT revoluționar nu a fost doar dimensiunea sa (deși la acea vreme, cei 117 milioane de parametri ai săi păreau enormi), ci și arhitectura de bază. Modelul de transformator, introdus de cercetătorii Google în lucrarea lor „Attention is All You Need”, s-a dovedit remarcabil de eficient în procesarea datelor secvențiale precum textul. Spre deosebire de rețelele neuronale recurente anterioare care procesau jetoane unul după altul, transformatoarele puteau analiza secvențe întregi simultan prin mecanismul lor de autoatenție.

Această procesare paralelă nu numai că a accelerat timpii de antrenament, dar a permis modelului să capteze mai bine dependențele pe distanță lungă în text. Dintr-o dată, AI ar putea să-și „amintească” ceea ce s-a menționat în paragrafele în urmă și să mențină coerența tematică în cadrul rezultatelor mai lungi. Pentru prima dată, textul generat de mașini a început să pară cu adevărat uman.

Era Scaling: de la GPT-2 la GPT-3

Dar adevăratul moment de turneu a venit cu GPT-3 în 2020. La 175 de miliarde de parametri – de peste 100 de ori mai mari decât GPT-2 – a reprezentat un salt cuantic în ceea ce privește capabilitățile. Modelul a prezentat ceea ce cercetătorii numesc „abilități emergente” – abilități pentru care nu a fost instruit în mod explicit, dar dezvoltate prin scară și expunere la date diverse.

Poate cel mai remarcabil, GPT-3 a arătat abilități rudimentare de „învățare cu câteva lovituri”. Cu doar câteva exemple în prompt, s-ar putea adapta la sarcini noi precum traducerea, rezumarea sau chiar codificarea de bază. Domeniul AI a început să recunoască faptul că scara nu doar îmbunătățește treptat performanța, ci schimba fundamental ceea ce puteau face aceste sisteme.

Dincolo de dimensiune: rafinament prin RLHF

Introduceți Reinforcement Learning from Human Feedback (RLHF). Această metodologie de instruire prezintă evaluatori umani care evaluează rezultatele modelului, creând o buclă de feedback care ajută AI să înțeleagă care răspunsuri sunt utile, veridice și inofensive. Modelele instruite cu RLHF, cum ar fi ChatGPT și Claude, s-au dovedit dramatic mai utile pentru sarcinile de zi cu zi, reducând în același timp rezultatele dăunătoare.

RLHF a marcat o schimbare crucială în filozofia dezvoltării AI. Puterea brută de predicție nu mai era suficientă – sistemele necesare pentru a înțelege nuanțele valorilor umane. Această abordare de instruire a ajutat modelele să răspundă în mod adecvat la subiecte sensibile, să refuze cererile neadecvate și să exprime incertitudinea, mai degrabă decât să afirme cu încredere falsuri.

Începe revoluția multimodală

Aceste sisteme au funcționat prin antrenarea modelelor de difuzie pe seturi de date vaste de perechi imagine-text. Învățând relația dintre conceptele vizuale și descrierile lor textuale, aceștia ar putea transforma indicații precum „un tablou suprarealist al unei pisici care joacă șah în stilul lui Salvador Dali” în imagini corespunzătoare.

În mod similar, modelele de recunoaștere a vorbirii au devenit din ce în ce mai precise, iar sistemele text-to-speech au devenit aproape imposibil de distins de vocile umane. Generarea video, deși încă se afla în fazele sale incipiente, a început să arate rezultate promițătoare cu sisteme precum Runway ML Gen-2 și Google Lumiere.

Fiecare modalitate a evoluat rapid, dar au rămas sisteme în mare măsură separate. Următoarea revoluție ar veni din unificarea acestor capacități.

Adevărata inteligență artificială multimodală: a vedea, a auzi și a înțelege

Aceste sisteme pot descrie ceea ce văd în imagini, pot extrage text din documente, pot analiza diagrame și grafice și chiar pot rezolva puzzle-uri vizuale. Un utilizator poate încărca o fotografie cu ingredientele din frigiderul său și poate întreba: „Ce pot găti cu acestea?” AI identifică apoi articolele și sugerează rețete adecvate.

Ceea ce face ca sistemele multimodale adevărate să fie diferite de simpla conectare a modelelor separate este înțelegerea lor unificată. Când întrebați despre un element dintr-o imagine, sistemul nu rulează doar recunoașterea separată a imaginii și apoi generarea de text, ci dezvoltă o înțelegere integrată între modalități. Acest lucru permite un raționament mai sofisticat, cum ar fi explicarea de ce o meme este amuzantă sau identificarea inconsecvențelor dintre text și imagini.

Testează AI pe site-ul TĂU în 60 de secunde

Vezi cum inteligența noastră artificială îți analizează instantaneu site-ul web și creează un chatbot personalizat - fără înregistrare. Introduci doar URL-ul tău și privești cum funcționează!

Arhitectura din spatele sistemelor multimodale

Arhitecturile multimodale moderne folosesc codificatori specializati pentru fiecare modalitate care transforma datele brute intr-un spatiu de reprezentare partajat. De exemplu, o imagine poate fi procesată de un transformator de viziune (ViT) care o descompune în patch-uri și le convertește în înglobare, în timp ce textul este tokenizat și încorporat separat. Aceste înglobări distincte sunt apoi proiectate într-un spațiu comun unde modelul de bază le poate procesa împreună.

Această arhitectură „turn și pod” permite modelelor să învețe relații intermodale – înțelegerea modului în care conceptele din limbaj corespund caracteristicilor vizuale sau modelelor audio. Când GPT-4 Vision recunoaște un reper într-o fotografie, poate conecta acea reprezentare vizuală cu cunoștințele sale textuale despre istoria, semnificația și contextul locației.

Procesul de instruire implică de obicei seturi masive de date de conținut asociat - imagini cu subtitrări, videoclipuri cu transcrieri și alte date multimodale aliniate. Învățând din aceste aliniamente, modelul construiește o reprezentare internă în care conceptele înrudite între modalități sunt mapate strâns împreună în spațiul său vectorial.

Aplicații din lumea reală ale IA multimodală

În asistența medicală, sistemele pot analiza imagini medicale împreună cu fișele și simptomele pacientului pentru a ajuta la diagnosticare. Un medic poate încărca o radiografie și poate pune întrebări specifice despre potențialele preocupări, primind informații care combină analiza vizuală cu cunoștințele medicale.

Pentru accesibilitate, inteligența artificială multimodală ajută utilizatorii nevăzători să înțeleagă conținutul vizual prin descrieri detaliate și îi ajută pe utilizatorii surzi oferind transcriere și traducere în timp real a conținutului vorbit.

În educație, aceste sisteme creează experiențe de învățare interactive în care elevii pot pune întrebări despre diagrame, fotografii istorice sau ecuații matematice, primind explicații adaptate stilului lor de învățare.

Creatorii de conținut folosesc AI multimodal pentru a genera active complementare - scriind articole și creând ilustrații potrivite sau produc videoclipuri educaționale cu imagini și narațiuni sincronizate.

Platformele de comerț electronic implementează căutarea vizuală în care clienții pot încărca o imagine a unui produs care le place și pot găsi articole similare, în timp ce AI descrie caracteristicile cheie cu care se potrivește.

Poate cel mai semnificativ, sistemele multimodale creează paradigme mai naturale de interacțiune om-calculator. În loc să ne adaptăm comunicarea pentru a se potrivi cu interfețele rigide ale computerelor, putem interacționa din ce în ce mai mult cu tehnologia în modurile în care comunicăm în mod natural unul cu celălalt – printr-o combinație fluidă de cuvinte, imagini, sunete și gesturi.

Limitări și considerații etice

Înțelegerea vizuală rămâne superficială în comparație cu percepția umană. În timp ce AI poate identifica obiecte și descrie scene, adesea ratează indicii vizuale subtile, relațiile spațiale și contextul cultural pe care oamenii le recunosc instantaneu. Cereți unui AI multimodal să explice o diagramă de inginerie complexă sau să interpreteze limbajul corpului într-o fotografie, iar limitările sale devin rapid evidente.

Aceste sisteme moștenesc și uneori amplifică părtinirile prezente în datele lor de antrenament. Componentele recunoașterii faciale pot avea rezultate mai proaste pe anumite grupuri demografice sau raționamentul vizual ar putea reflecta prejudecăți culturale în modul în care sunt interpretate imaginile.

Preocupările privind confidențialitatea sunt sporite cu sistemele multimodale, deoarece procesează date vizuale și audio potențial sensibile. Un utilizator ar putea partaja o imagine fără să-și dea seama că conține informații personale în fundal pe care AI le poate recunoaște și eventual să le încorporeze în răspunsurile sale.

Poate cea mai presantă problemă este potențialul AI multimodal de a crea medii sintetice convingătoare - deepfake-uri care combină imagini realiste, video și audio pentru a crea conținut persuasiv, dar fabricat. Pe măsură ce aceste tehnologii devin mai accesibile, societatea se confruntă cu întrebări urgente despre autenticitatea media și alfabetizarea digitală.

Viitorul: de la IA multimodală la IA multisenzorială

Cercetările emergente explorează inteligența artificială încorporată – sisteme conectate la platforme robotice care pot interacționa fizic cu lumea, combinând percepția cu acțiunea. Un robot echipat cu IA multimodală ar putea recunoaște obiectele vizual, să înțeleagă instrucțiuni verbale și să-și manipuleze mediul în consecință.

De asemenea, vedem lucrări timpurii asupra sistemelor AI care pot menține memoria persistentă și pot construi înțelegerea contextuală în cadrul interacțiunilor extinse. În loc să trateze fiecare conversație ca fiind izolată, aceste sisteme ar dezvolta o relație continuă cu utilizatorii, amintindu-și interacțiunile din trecut și preferințele de învățare de-a lungul timpului.

Poate că cea mai transformatoare dezvoltare va fi sistemele de inteligență artificială care pot realiza lanțuri complexe de raționament în diferite modalități - să vadă o problemă mecanică, să raționeze despre principiile fizicii și să sugereze soluții care integrează înțelegerea vizuală, textuală și spațială.

Pe măsură ce aceste tehnologii continuă să se dezvolte, vor estompa din ce în ce mai mult liniile dintre instrumentele specializate și asistenții de uz general, ceea ce poate duce la sisteme AI care pot aborda în mod flexibil aproape orice sarcină de procesare a informațiilor pe care o poate descrie un om.

Concluzie: Navigarea în viitorul multimodal

Această accelerare nu dă semne de încetinire și probabil că suntem încă în primele capitole ale poveștii AI. Pe măsură ce aceste sisteme continuă să evolueze, ele vor remodela modul în care lucrăm, învățăm, creăm și comunicăm.

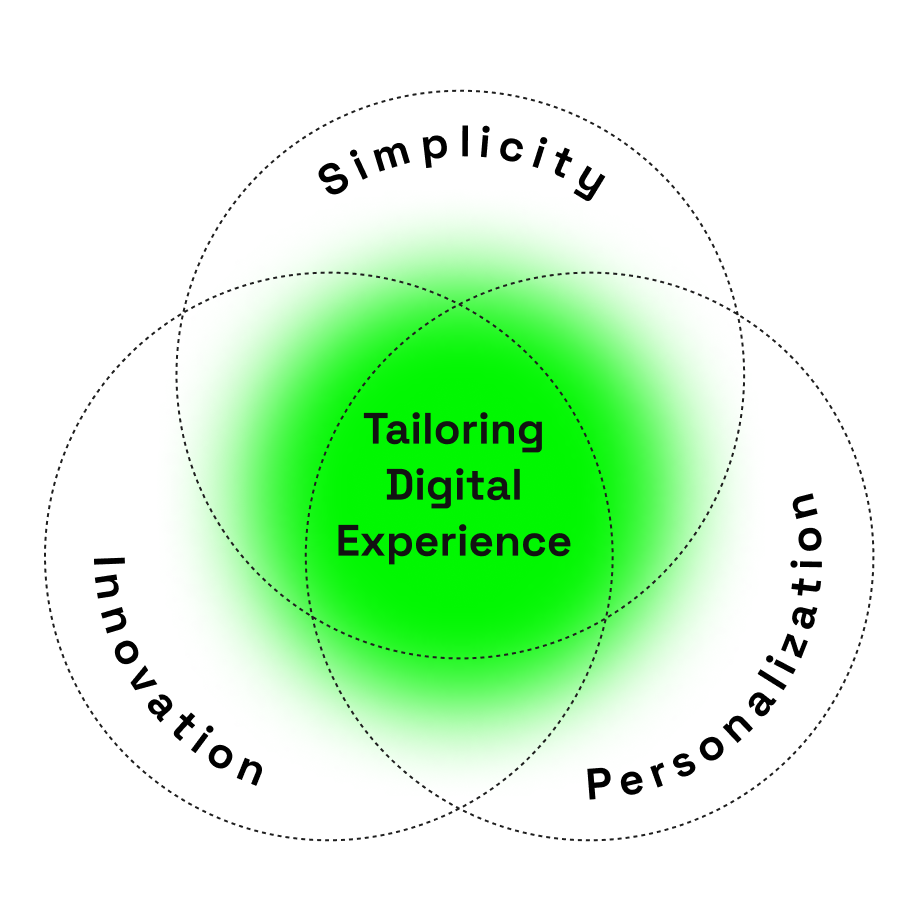

Pentru dezvoltatori, paradigma multimodală deschide noi posibilități pentru a crea interfețe mai intuitive și mai accesibile. Pentru companii, aceste tehnologii oferă oportunități de automatizare a fluxurilor de lucru complexe și de îmbunătățire a experienței clienților. Pentru indivizi, AI multimodal oferă instrumente puternice pentru creativitate, productivitate și acces la informații.

Cu toate acestea, navigarea în acest viitor necesită o analiză atentă atât a capacităților, cât și a limitărilor. Cele mai eficiente aplicații vor fi cele care valorifică punctele forte ale AI, ținând cont de punctele sale slabe, creând colaborări om-AI care ne amplifică abilitățile colective.

Evoluția de la GPT la AI multimodală nu este doar o realizare tehnică, ci este o schimbare fundamentală în relația noastră cu tehnologia. Trecem de la computere care execută comenzi la asistenți care înțeleg contextul, interpretează sensul în diferite modalități și se implică în bogăția și ambiguitatea comunicării umane. Această tranziție va continua să se desfășoare în moduri surprinzătoare și transformatoare în anii următori.