Testează AI pe site-ul TĂU în 60 de secunde

Vezi cum inteligența noastră artificială îți analizează instantaneu site-ul web și creează un chatbot personalizat - fără înregistrare. Introduci doar URL-ul tău și privești cum funcționează!

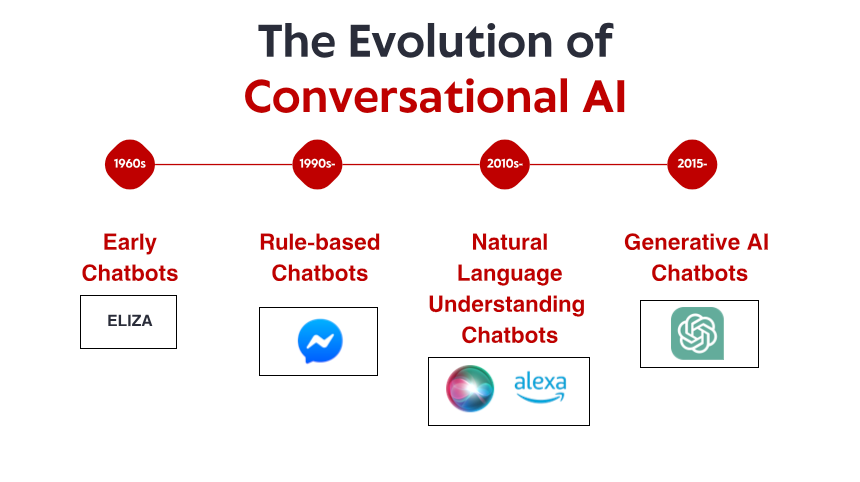

Începuturile umile: sisteme timpurii bazate pe reguli

Ceea ce a făcut-o remarcabilă pe ELIZA nu a fost sofisticarea sa tehnică – după standardele actuale, programul era incredibil de simplu. Mai degrabă, a fost efectul profund pe care l-a avut asupra utilizatorilor. În ciuda faptului că știau că vorbesc cu un program de calculator fără înțelegere reală, mulți oameni au format conexiuni emoționale cu ELIZA, împărtășind gânduri și sentimente profund personale. Acest fenomen, pe care însuși Weizenbaum l-a găsit deranjant, a dezvăluit ceva fundamental despre psihologia umană și despre disponibilitatea noastră de a antropomorfiza chiar și cele mai simple interfețe conversaționale.

De-a lungul anilor 1970 și 1980, chatbot-urile bazate pe reguli au urmat șablonul ELIZA cu îmbunătățiri progresive. Programe precum PARRY (simulează un schizofrenic paranoic) și RACTER (care a „autorizat” o carte numită „Barba polițistului este pe jumătate construită”) au rămas ferm în paradigma bazată pe reguli – folosind modele predefinite, potrivirea cuvintelor cheie și răspunsuri șablon.

Aceste sisteme timpurii au avut limitări severe. Nu puteau să înțeleagă limba, să învețe din interacțiuni sau să se adapteze la intrări neașteptate. Cunoștințele lor erau limitate la orice reguli definite în mod explicit de programatorii lor. Când utilizatorii s-au rătăcit inevitabil în afara acestor granițe, iluzia inteligenței s-a spulberat rapid, dezvăluind natura mecanică de dedesubt. În ciuda acestor constrângeri, aceste sisteme de pionierat au stabilit fundația pe care s-ar construi toată IA conversațională viitoare.

Revoluția cunoașterii: sisteme experte și informații structurate

Sisteme experte precum MYCIN (care a diagnosticat infecțiile bacteriene) și DENDRAL (care a identificat compuși chimici) au organizat informațiile în baze de cunoștințe structurate și au folosit motoare de inferență pentru a trage concluzii. Când este aplicată interfețelor conversaționale, această abordare le-a permis chatboților să treacă dincolo de simpla potrivire a modelelor către ceva asemănător raționamentului – cel puțin în domenii înguste.

Companiile au început să implementeze aplicații practice, cum ar fi sisteme automate de servicii pentru clienți, folosind această tehnologie. Aceste sisteme foloseau de obicei arbori de decizie și interacțiuni bazate pe meniuri, mai degrabă decât conversații în formă liberă, dar au reprezentat încercări timpurii de automatizare a interacțiunilor care anterior necesitau intervenția umană.

Limitările au rămas semnificative. Aceste sisteme erau fragile, incapabile să gestioneze intrările neașteptate cu grație. Au fost necesare eforturi enorme din partea inginerilor de cunoștințe pentru a codifica manual informațiile și regulile. Și poate cel mai important, ei încă nu au putut înțelege cu adevărat limbajul natural în întreaga sa complexitate și ambiguitate.

Cu toate acestea, această epocă a stabilit concepte importante care mai târziu aveau să devină cruciale pentru IA conversațională modernă: reprezentarea structurată a cunoștințelor, inferența logică și specializarea domeniului. Se pregătea scena pentru o schimbare de paradigmă, deși tehnologia nu era încă acolo.

Înțelegerea limbajului natural: descoperirea lingvisticii computaționale

Această schimbare a fost posibilă de mai mulți factori: creșterea puterii de calcul, algoritmi mai buni și, în mod esențial, disponibilitatea unor corpuri mari de text care ar putea fi analizate pentru a identifica modele lingvistice. Sistemele au început să încorporeze tehnici precum:

Etichetarea unei părți de vorbire: identificarea dacă cuvintele funcționau ca substantive, verbe, adjective etc.

Recunoașterea entităților numite: detectarea și clasificarea numelor proprii (persoane, organizații, locații).

Analiza sentimentelor: Determinarea tonului emoțional al textului.

Analiza: analiza structurii propoziției pentru a identifica relațiile gramaticale dintre cuvinte.

O descoperire notabilă a venit cu Watson de la IBM, care a învins campioni umani în emisiunea de test Jeopardy! în 2011. Deși nu este un sistem strict de conversație, Watson a demonstrat abilități fără precedent de a înțelege întrebările legate de limbajul natural, de a căuta în depozite vaste de cunoștințe și de a formula răspunsuri – capabilități care s-ar dovedi esențiale pentru următoarea generație de chatbot.

Au urmat curând aplicații comerciale. Siri de la Apple a fost lansat în 2011, aducând interfețe conversaționale consumatorilor mainstream. Deși limitat de standardele actuale, Siri a reprezentat un progres semnificativ în a face asistenții AI accesibili utilizatorilor obișnuiți. Ar urma Cortana de la Microsoft, Asistentul Google și Alexa de la Amazon, fiecare împingând mai departe stadiul tehnicii în IA conversațională orientată spre consumatori.

În ciuda acestor progrese, sistemele din această epocă încă se luptă cu contextul, raționamentul de bun simț și generarea de răspunsuri cu adevărat naturale. Erau mai sofisticați decât strămoșii lor bazați pe reguli, dar au rămas fundamental limitați în înțelegerea limbii și a lumii.

Învățarea automată și abordarea bazată pe date

Această epocă a văzut creșterea clasificării intențiilor și a extragerii entităților ca componente de bază ale arhitecturii conversaționale. Când un utilizator a făcut o solicitare, sistemul ar:

Clasificați intenția generală (de exemplu, rezervarea unui zbor, verificarea vremii, redarea muzicii)

Extrageți entitățile relevante (de exemplu, locații, date, titluri de melodii)

Mapați acestea cu acțiuni sau răspunsuri specifice

Lansarea de către Facebook (acum Meta) a platformei sale Messenger în 2016 a permis dezvoltatorilor să creeze chatbot-uri care ar putea ajunge la milioane de utilizatori, stârnind un val de interes comercial. Multe companii s-au grăbit să implementeze chatbot, deși rezultatele au fost mixte. Implementările comerciale timpurii au frustrat adesea utilizatorii cu înțelegere limitată și fluxuri de conversații rigide.

Arhitectura tehnică a sistemelor conversaționale a evoluat și ea în această perioadă. Abordarea tipică a implicat o conductă de componente specializate:

Recunoaștere automată a vorbirii (pentru interfețe vocale)

Înțelegerea limbajului natural

Gestionarea dialogurilor

Generația limbajului natural

Text-to-Speech (pentru interfețe vocale)

Fiecare componentă ar putea fi optimizată separat, permițând îmbunătățiri progresive. Cu toate acestea, aceste arhitecturi de conducte au suferit uneori din cauza propagării erorilor – greșelile din stadiile incipiente s-au scurs prin sistem.

În timp ce învățarea automată a îmbunătățit semnificativ capacitățile, sistemele încă s-au luptat cu menținerea contextului pe parcursul conversațiilor lungi, înțelegerea informațiilor implicite și generarea de răspunsuri cu adevărat diverse și naturale. Următoarea descoperire ar necesita o abordare mai radicală.

Revoluția transformatoarelor: modele de limbaj neuronal

Această inovație a permis dezvoltarea unor modele de limbaj din ce în ce mai puternice. În 2018, Google a introdus BERT (Bidirectional Encoder Representations from Transformers), care a îmbunătățit dramatic performanța la diferite sarcini de înțelegere a limbajului. În 2019, OpenAI a lansat GPT-2, demonstrând abilități fără precedent în generarea de text coerent, relevant din punct de vedere contextual.

Cel mai dramatic salt a avut loc în 2020 cu GPT-3, mărind până la 175 de miliarde de parametri (comparativ cu cei 1,5 miliarde de GPT-2). Această creștere masivă a dimensiunii, combinată cu rafinamentele arhitecturale, a produs capacități calitativ diferite. GPT-3 ar putea genera un text remarcabil de uman, să înțeleagă contextul în mii de cuvinte și chiar să îndeplinească sarcini pentru care nu a fost instruit în mod explicit.

Pentru IA conversațională, aceste progrese s-au tradus în chatbot-uri care ar putea:

Mențineți conversații coerente pe mai multe rânduri

Înțelegeți interogările nuanțate fără instruire explicită

Generați răspunsuri diverse, adecvate contextului

Adaptați-le tonul și stilul pentru a se potrivi cu utilizatorul

Gestionați ambiguitatea și clarificați atunci când este necesar

Lansarea ChatGPT la sfârșitul anului 2022 a adus aceste capacități în curent, atrăgând peste un milion de utilizatori în câteva zile de la lansare. Dintr-o dată, publicul larg a avut acces la IA conversațională care părea calitativ diferită de orice a apărut înainte – mai flexibilă, mai informată și mai naturală în interacțiunile sale.

Au urmat rapid implementările comerciale, companiile încorporând modele de limbă mari în platformele lor de servicii pentru clienți, instrumente de creare de conținut și aplicații de productivitate. Adoptarea rapidă a reflectat atât saltul tehnologic, cât și interfața intuitivă oferită de aceste modele – conversația este, până la urmă, cea mai naturală modalitate prin care oamenii pot comunica.

Testează AI pe site-ul TĂU în 60 de secunde

Vezi cum inteligența noastră artificială îți analizează instantaneu site-ul web și creează un chatbot personalizat - fără înregistrare. Introduci doar URL-ul tău și privești cum funcționează!

Capabilități multimodale: dincolo de conversațiile numai text

Modelele în limbajul vizual precum DALL-E, Midjourney și Stable Diffusion au demonstrat capacitatea de a genera imagini din descrieri textuale, în timp ce modele precum GPT-4 cu capacități de viziune ar putea analiza imaginile și discuta despre ele în mod inteligent. Acest lucru a deschis noi posibilități pentru interfețele conversaționale:

Boti de servicii pentru clienți care pot analiza fotografiile produselor deteriorate

Asistenți de cumpărături care pot identifica articole din imagini și pot găsi produse similare

Instrumente educaționale care pot explica diagrame și concepte vizuale

Caracteristici de accesibilitate care pot descrie imagini pentru utilizatorii cu deficiențe de vedere

Capacitățile de voce au avansat, de asemenea, dramatic. Interfețele de vorbire timpurii, cum ar fi sistemele IVR (Interactive Voice Response) au fost notoriu frustrante, limitate la comenzi rigide și structuri de meniu. Asistenții vocali moderni pot înțelege tiparele naturale de vorbire, pot ține cont de diferite accente și impedimente de vorbire și pot răspunde cu voci sintetizate cu sunet din ce în ce mai natural.

Fuziunea acestor capabilități creează o inteligență artificială conversațională cu adevărat multimodală, care poate comuta fără probleme între diferite moduri de comunicare în funcție de context și de nevoile utilizatorului. Un utilizator poate începe cu o întrebare text despre repararea imprimantei, trimite o fotografie a mesajului de eroare, primește o diagramă care evidențiază butoanele relevante și apoi trece la instrucțiuni vocale în timp ce mâinile sunt ocupate cu reparația.

Această abordare multimodală reprezintă nu doar un progres tehnic, ci și o schimbare fundamentală către o interacțiune mai naturală om-calculator - întâlnirea utilizatorilor în orice mod de comunicare funcționează cel mai bine pentru contextul și nevoile lor actuale.

Recuperare-Augmented Generation: Grounding AI in facts

Retrieval-Augmented Generation (RAG) a apărut ca o soluție la aceste provocări. În loc să se bazeze doar pe parametrii învățați în timpul antrenamentului, sistemele RAG combină abilitățile generative ale modelelor lingvistice cu mecanisme de regăsire care pot accesa surse externe de cunoștințe.

Arhitectura tipică RAG funcționează astfel:

Sistemul primește o interogare de utilizator

Acesta caută baze de cunoștințe relevante pentru informații relevante pentru interogare

Acesta furnizează atât interogarea, cât și informațiile preluate în modelul de limbă

Modelul generează un răspuns bazat pe faptele preluate

Această abordare oferă mai multe avantaje:

Răspunsuri mai precise, concrete, prin generarea de informații verificate

Abilitatea de a accesa informații actualizate dincolo de limita de antrenament a modelului

Cunoștințe specializate din surse specifice domeniului, cum ar fi documentația companiei

Transparență și atribuire prin citarea surselor de informare

Pentru companiile care implementează IA conversațională, RAG s-a dovedit deosebit de valoroasă pentru aplicațiile de servicii pentru clienți. Un chatbot bancar, de exemplu, poate accesa cele mai recente documente de politică, informații despre cont și înregistrări ale tranzacțiilor pentru a oferi răspunsuri precise și personalizate care ar fi imposibile cu un model de limbaj independent.

Evoluția sistemelor RAG continuă cu îmbunătățiri ale preciziei de regăsire, metode mai sofisticate de integrare a informațiilor preluate cu textul generat și mecanisme mai bune de evaluare a fiabilității diferitelor surse de informații.

Modelul de colaborare om-AI: găsirea echilibrului potrivit

Cele mai de succes implementări de astăzi urmează un model colaborativ în care:

AI gestionează interogări de rutină, repetitive, care nu necesită judecată umană

Oamenii se concentrează pe cazuri complexe care necesită empatie, raționament etic sau rezolvare creativă a problemelor

Sistemul își cunoaște limitările și escaladează fără probleme la agenți umani atunci când este cazul

Tranziția între AI și suport uman este fără probleme pentru utilizator

Agenții umani au contextul complet al istoriei conversațiilor cu AI

AI continuă să învețe din intervențiile umane, extinzându-și treptat capacitățile

Această abordare recunoaște că inteligența artificială conversațională nu ar trebui să vizeze înlocuirea completă a interacțiunii umane, ci mai degrabă să o completeze – gestionând interogări simple și de mare volum, care consumă timpul agenților umani, asigurând în același timp că problemele complexe ajung la expertiza umană potrivită.

Implementarea acestui model variază în funcție de industrii. În domeniul sănătății, chatboții AI se pot ocupa de programarea întâlnirilor și de screeningul simptomelor de bază, asigurându-se în același timp că sfatul medical vine de la profesioniști calificați. În serviciile juridice, AI ar putea ajuta la pregătirea și cercetarea documentelor, lăsând interpretarea și strategia în seama avocaților. În serviciul pentru clienți, AI poate rezolva probleme comune în timp ce direcționează probleme complexe către agenți specializați.

Pe măsură ce capabilitățile AI continuă să avanseze, linia dintre ceea ce necesită implicarea umană și ceea ce poate fi automatizat se va schimba, dar principiul fundamental rămâne: IA conversațională eficientă ar trebui să îmbunătățească capacitățile umane, mai degrabă decât să le înlocuiască pur și simplu.

Peisajul viitorului: unde se îndreaptă IA conversațională

Personalizare la scară: sistemele viitoare își vor adapta din ce în ce mai mult răspunsurile nu doar la contextul imediat, ci și la stilul de comunicare, preferințele, nivelul de cunoștințe și istoricul relațiilor fiecărui utilizator. Această personalizare va face interacțiunile să se simtă mai naturale și mai relevante, deși ridică întrebări importante despre confidențialitate și utilizarea datelor.

Inteligența emoțională: în timp ce sistemele actuale pot detecta sentimentele de bază, viitoarea IA conversațională va dezvolta o inteligență emoțională mai sofisticată – recunoscând stările emoționale subtile, răspunzând în mod adecvat la suferință sau frustrare și adaptându-și tonul și abordarea în consecință. Această capacitate va fi deosebit de valoroasă în aplicațiile de servicii pentru clienți, asistență medicală și educație.

Asistență proactivă: în loc să aștepte interogări explicite, sistemele conversaționale de ultimă generație vor anticipa nevoile bazate pe context, istoricul utilizatorilor și semnalele de mediu. Un sistem ar putea observa că programați mai multe întâlniri într-un oraș necunoscut și că oferiți în mod proactiv opțiuni de transport sau prognoze meteo.

Integrare multimodală fără întreruperi: sistemele viitoare vor trece dincolo de simpla susținere a diferitelor modalități pentru a le integra perfect. O conversație poate curge natural între text, voce, imagini și elemente interactive, alegând modalitatea potrivită pentru fiecare informație fără a necesita o selecție explicită a utilizatorului.

Experți în domeniu specializați: în timp ce asistenții de uz general vor continua să se îmbunătățească, vom vedea, de asemenea, creșterea IA conversațională foarte specializată, cu o expertiză profundă în domenii specifice - asistenți juridici care înțeleg jurisprudența și precedentul, sisteme medicale cu cunoștințe complete despre interacțiunile medicamentoase și protocoalele de tratament sau consilieri financiari versați în codurile fiscale și strategiile de investiții.

Învățare cu adevărat continuă: sistemele viitoare vor trece dincolo de recalificarea periodică la învățarea continuă din interacțiuni, devenind mai utile și personalizate în timp, menținând în același timp garanții de confidențialitate adecvate.

În ciuda acestor posibilități interesante, provocările rămân. Preocupările privind confidențialitatea, atenuarea prejudecăților, transparența adecvată și stabilirea nivelului corect de supraveghere umană sunt probleme permanente care vor modela atât tehnologia, cât și reglementarea acesteia. Cele mai de succes implementări vor fi cele care abordează aceste provocări cu atenție, oferind în același timp valoare reală utilizatorilor.

Ceea ce este clar este că inteligența artificială conversațională a trecut de la o tehnologie de nișă la o paradigmă de interfață principală care va media din ce în ce mai mult interacțiunile noastre cu sistemele digitale. Calea evolutivă de la modelul simplu de potrivire a ELIZA la modelele de limbaj sofisticate de astăzi reprezintă unul dintre cele mai semnificative progrese în interacțiunea om-calculator – iar călătoria este departe de a fi încheiată.